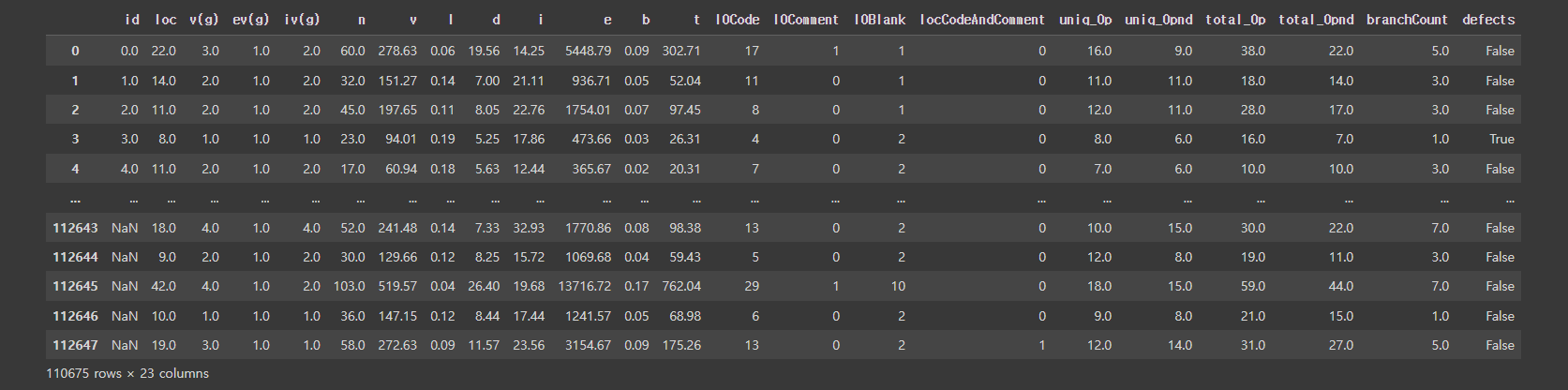

저번에 나갔던 대회 코드에 Optuna를 적용해서 하이퍼 튜닝을 해보겠다. Optuna는 매 trial마다 정해진 범위에서 suggest된 하이퍼파라미터 값을 이용해서 trial을 진행하고 매 trial은 이전 trial의 기록을 확인해서 좋은 점수대가 나오는 곳을 기준으로 집중적으로 학습한다고 했다.(이게 진짜인지가 젤 궁금해서 실험해봤다.) 당연히 무작정 모든 경우의 수를 비교할려는 GridSearch보다 효율적일거라고 생각했지만 점수가 과연 더 좋게 나올까라는 의구심이 들어 기존 대회에서 만들었던 코드를 수정해 봤다. skf = StratifiedKFold(n_splits = 10, shuffle=True,random_state=42) import numpy as np from sklearn.mod..